深度学习赋能下的光学计量:让“老司机”搭上“顺风车”

撰稿 | 左 超 钱佳铭

2016年3月,谷歌旗下人工智能(AI)公司DeepMind凭借其开发的AlphaGo人工智能系统以总比分4:1战胜围棋世界冠军李世石,引发了全人类对新一轮人工智能浪潮——深度学习技术的广泛关注和持续热议。从那刻起,人们见证了深度学习技术的快速崛起和广泛应用——它以前所未有的性能解决了计算机视觉、计算成像和计算机辅助诊断等领域的诸多难题与挑战。与此同时,Google、Facebook、微软、苹果和亚马逊这五大科技巨头无一例外投入越来越多资源抢占人工智能市场,甚至整体转型为人工智能驱动的公司。它们开始“点燃”数据挖掘的“艺术”,并开发出易于使用的开源深度学习框架。这些深度学习框架使我们能够使用预先构建和优化的组件集合,以更清晰、简明和用户友好的方式构建复杂、大规模的深度学习模型,而无需深入了解底层算法的细节。国内“BAT”也将深度学习技术作为重点战略方向,凭借自身优势积极布局人工智能领域。深度学习已经迅速地离开了学术界的殿堂并开始重塑工业界。

另一方面,光学计量学(Optical Metrology)是一类以光信号为标准/信息载体的测量科学和技术。它是一门古老的学科,因为物理学的发展从一开始就由光学计量技术所驱动的。但反过来,光学计量学也因激光、电荷耦合器件(CCD)和计算机的发明而发产生了重大变革。现如今已发展成为一个涵盖广泛的跨学科领域,并与光测力学、光学工程、计算机视觉和计算成像等学科紧密相关。鉴于深度学习在这些相关领域所取得的巨大成功,光学计量学的研究人员也无法抑制他们的好奇心,也开始积极投身到这一快速发展的新兴领域中。不同于传统的基于“物理先验”方法,基于“数据驱动”的深度学习技术为解决光学计量领域的诸多挑战性问题提供了新的可能,并展现出了巨大的应用潜力。

在此背景下,2022年3月,南京理工大学与新加坡南洋理工大学的研究团队在国际顶级光学期刊《Light: Science & Applications》上联合发表了题为“Deep learning in optical metrology: a review“的综述文章,文章第一作者为南京理工大学左超教授,南京理工大学博士研究生钱佳铭为共同第一作者,南京理工大学左超、陈钱教授、新加坡南洋理工大学钱克矛教授为论文的共同通讯作者,南京理工大学为论文的第一单位。文章系统总结了光学计量学中经典技术与图像处理算法,简述了深度学习的发展历史、网络结构及技术优势,并对其在各种光学计量任务中(如条纹去噪、相位解调和相位展开)的具体应用进行了全面综述。通过对比深度学习方法与传统图像处理算法的原理与思想上的异同,展示了深度学习在解决各种光学计量任务中“问题重构”和“实际性能”方面的独特优势。最后文章指出了深度学习技术在光学计量领域所面临的挑战,并展望了其未来潜在的发展方向。

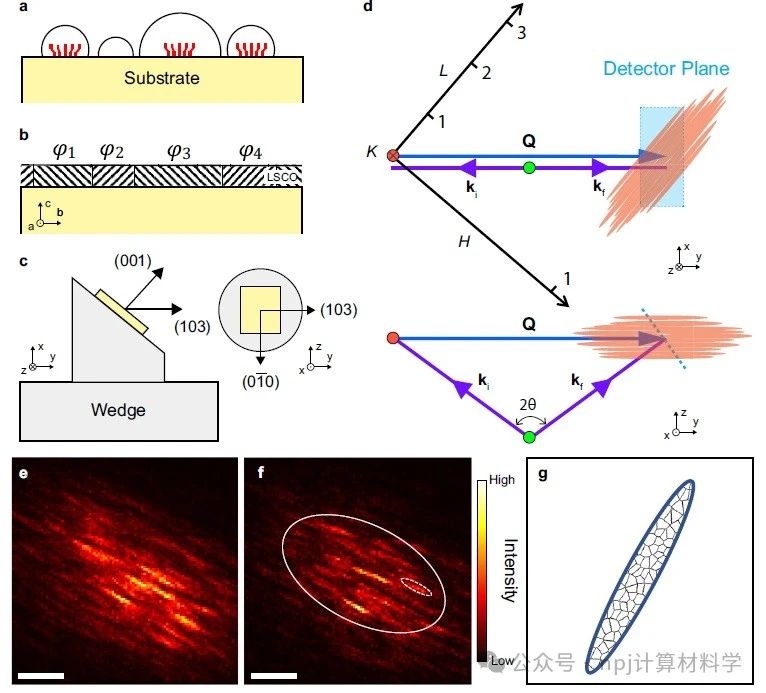

光学计量技术将光的基本属性(如振幅、相位、波长、方向、频率、速度、偏振和相干性等)巧妙地用作被测物的信息载体,以实现对被测物的各种特征数据(如距离、位移、尺寸、形貌、粗糙度、应变和应力等)的获取1。光学计量因其非接触、高速、高灵敏度、高分辨率、高精度等优势,在CAD /CAE、逆向工程、在线检测、质量控制、医疗诊断、文物保护、人机交互等领域得到了日益广泛的应用。在光学计量技术中,最常见信息载体为“条纹”与“散斑”。如大多数干涉测量法(经典干涉、光弹、数字散斑、数字全息等)所处理的图像是由物光和参考光相干叠加而成的干涉条纹,被测物理量被调制于干涉条纹的相位信息中2–5;此外,条纹图案还可以非干涉的方式生成,如条纹投影轮廓术(FPP)直接投影结构光条纹图案至被测物表面以测量物体的三维面型6。而在数字图像相关(DIC)中,所拍摄的图像则是样品表面形变前后的散斑图案,从中可获得被测物全场位移和形变分布7;将DIC与立体视觉或摄影测量相结合,基于多视散斑图像还可获取被测场景的深度信息8。图1总结了这些技术的图像生成过程及其对应的数学模型。

图1 传统光学计量技术中的图像生成过程及对应的数学模型

传统光学计量离不开图像处理技术,对条纹/散斑的图像处理可以理解为由捕获的原始强度图像反演出所需的待测物理量的过程。通常情况下,该过程并非“一步到位”,而是由三个具有逻辑层次的图像处理步骤所构成——预处理、分析和后处理。每个步骤都包含一系列图像处理算法,这些算法层层叠加,形成一个“流水线”结构[图2],其中每个算法对应于一个“映射”运算,其将图像/类似图像的矩阵输入转化为相应维度(或重采样的)的输出。

(1)预处理:图像预处理通过抑制或最小化不必要的干扰信号(如噪声、混叠、畸变等)来提高图像质量,光学计量中代表性的图像预处理算法包括图像去噪9、图像增强10、颜色通道分离11、图像配准与校正12等。

(2)分析:图像分析是图像处理算法的核心步骤,用于从输入图像中提取与待测物理量相关的重要信息载体。在相位测量技术中,图像分析的主要任务是从条纹图像中重建相位信息,其基本算法包括相位解调13与相位展开14;对于立体匹配技术,图像分析是指确定散斑图像(样品表面形变前后的散斑图案/多视散斑图像)对应点间的位移向量,一般包括子集匹配和亚像素优化两个步骤15。

(3)后处理:图像后处理的目的是进一步优化测量得到的相位数据或散斑位移场,并最终将它们转化为待测物理量。光学计量中常见的后处理算法包括去噪16、误差补偿17、数字重聚焦18、参量转换19等。图3给出了光学计量图像处理层次结构的概貌以及不同层中分布的各种图像处理算法。

图2 光学计量的典型图像处理过程(如条纹投影轮廓术)可分为三个主要步骤:预处理(如去噪、图像增强)、分析(如相位解调、相位展开)和后处理(如相位—深度映射)

图3 光学计量图像处理层次结构的概貌以及不同层中分布的各种图像处理算法

深度学习是机器学习领域的一个重要分支,它通过构建模拟人脑信息处理神经结构的人工神经网络(ANN),使机器能够从大量历史数据中进行自底向上的特征提取,从而实现对未来/未知样本的智能决策。ANN起源于McCulloch和Pitts在1943年建立的生物神经元的简化数学模型20[图4a]。1958年,Rosenblatt等21受生物神经元模型的启发首次提出了可模拟人类感知能力的机器——单层感知机。如图4b所示,单层感知机由单个神经元构成,神经元以偏置(b)和权重(w)为参数,通过非线性激活函数将输入映射到输出。感知器的提出激发了大量研究人员对ANN的兴趣,对神经网络的发展具有里程碑式意义。然而,单层感知器只能处理线性分类问题的局限致使随后神经网络的发展停滞了近20年。80 年代,反向传播(BP)算法的提出使多层神经网络的高效训练成为了可能。其基于链式法则不断调节神经元间的权值以减小多层网络的输出误差,有效解决了非线性分类和学习的问题,引发了“浅层学习”的繁荣22。1989年,LeCun等23受哺乳动物视觉皮层结构启发提出了卷积神经网络(CNN)的思想,为现代计算机视觉与图像处理奠定了深度学习的基础。随后随着神经网络层数的增加,BP算法的梯度消失/爆炸问题日益凸显,致使90年代中期ANN的发展又陷入了停滞。2006年,Hinton等24提出了一种深度置信网络(DBN)的训练方法来应对梯度消失问题;同时伴随着计算机硬件性能、GPU加速技术的发展以及大量标记数据集的出现,神经网络步入了第三次发展高潮,从“浅层学习”阶段迈入了“深度学习”阶段。2012年,基于CNN构架的AlexNet于ImageNet图像识别比赛中一举夺魁,使得沉寂20余年的CNN成为深度学习的主流框架之一25。与此同时,一些新的深度学习网络架构及训练方法(如ReLU26和Dropout27)被提出以进一步解决梯度消失问题,促使了深度学习的爆炸式增长。2016 年,谷歌旗下AI公司DeepMind所开发的人工智能系统AlphaGo击败围棋世界冠军李世石,引发了全人类对深度学习技术的广泛关注28。图4给出了人工神经网络和深度学习技术的发展历程与典型神经网络的结构示意图。

图4 深度学习与人工神经网络的发展历程及典型神经网络的结构示意图

图5 用于图像分类任务的典型CNN结构

a) 典型的CNN包括输入层、卷积层、全连接层和输出层 b) 卷积运算 c) 池化操作

上述单层感知机是最简单的ANN结构,仅由单个神经元构成[图4b]。深度神经网络(DNN)由多层神经元相互连接而成,相邻层间的神经元通常以全连接形式堆叠[图4g]。在网络训练期间,神经元将相应的输入乘以一个权重系数并与偏置值相加,通过非线性激活函数输出至下一层,同时网络损失被计算并反向传播以更新网络参数。不同于常规的全连接层,CNN使用卷积层对输入数据进行特征提取29[图5a]。在每一层中,输入图像与一组卷积滤波器和添加的偏置进行卷积以生成一个新的输出图像[图5b]。CNN中的池化层利用图像的局部相关性原理对图像进行子抽样,在减少数据处理量的同时保留了有用信息[图5c]。这些特征使得CNN广泛应用于计算机视觉的任务中,如目标检测30和运动跟踪31等。传统的CNN构架大多面向“分类”任务,在输出端舍弃了空间信息并产生了“向量”形式的输出。然而,对于光学计量技术中的图像处理任务,神经网络必须能够产生一个与输入相同的(甚至更高)全分辨率输出。为此应该使用没有全连接层的全卷积网络结构,这样的网络构架接受任意尺寸的输入,用回归损失进行训练,并产生像素级的矩阵输出。具有此类特征的网络称为“全卷积网络结构”的CNN,其网络架构主要包括以下三类:

(1)SRCNN:Dong等32跳过传统CNN结构中的池化层,采用几个卷积层简单堆叠的方式在输出端保留了输入维度[图6a]。利用该思想构建的SRCNN成为用于图像超分辨任务的主流网络框架之一。

(2)FCN:全卷积网络(FCN)是由Long等提出的用于语义分割任务的网络框架33。如图6b所示,FCN使用传统CNN[图5]的卷积层作为网络编码模块,将全连接层替换为反卷积层作为解码模块。反卷积层能够对最后一个卷积层的特征图进行上采样使其恢复到与输入图像相同尺寸的输出。此外,FCN通过跳级结构将粗糙的高层特征与细致的低层特征相结合,使网络在保留像素级输出的同时更好地恢复了细节信息。

(3)U-Net:Ronneberger等对FCN作出改进并提出U-Net网络34。如图6c所示,U-Net的基本结构包括一个压缩路径和一个扩展路径。压缩路径作为网络的编码器,使用四个卷积块(每个卷积块由三个卷积层和一个池化层构成)对输入图像进行降采样并获得压缩特征表示;扩展路径作为网络解码器使用转置卷积的上采样方法来输出与输入相同尺寸的预测结果。U-Net采用跳跃连接对压缩路径和扩展路径进行特征融合,使得网络可以在浅层特征和深层特征中自由选择,对语义分割任务来说更有优势。

上述全卷积网络结构的CNN能够将任意大小的输入图像转化为像素级的矩阵输出,这与光学计量任务中图像处理算法所对应的“映射”运算的输入输出特征完全吻合,因此可以非常方便地对传统图像处理任务进行“深度学习替换”,这为深度学习在光学计量领域的快速崛起奠定了基石。

图6 三种能够产生像素级图像输出的用于图像处理任务的代表性全卷积网络结构的CNN

a) SRCNN b) FCN c) U-Net。

在光学计量技术中,原始条纹/散斑图像与被测物理量间的映射可描述为从参数空间到图像空间的正向物理模型和测量噪声的组合,这可以解释光学计量中几乎所有原始图像的生成过程。但从原始图像中提取待测物理量是一个典型的“逆问题”。求解这样的逆问题面临着诸多挑战,如:未知或不精确的正向物理模型、误差累积和局部最优解以及逆问题的病态性等。在计算机视觉和计算成像领域,解决逆问题的经典方法是通过引入被测物的先验作为正则化手段限定解空间以使其良态化[图7]。而在光学计量领域,解决逆问题的思路则与之大相径庭。根本原因在于光学计量通常是在一个“高度可控”的环境中进行的,因此更倾向于通过一系列“主动策略”,如照明调制、物体调控、多次曝光等来“主动调整”图像的采集过程,这就可将原先的“病态逆问题”重塑为一个“良态且足够稳定的回归问题”。例如由单幅条纹图像解调绝对相位:由于正向物理模型中缺乏足够的信息可以用来唯一稳定地求解相应的逆问题,该逆问题是病态的。而对于光学计量的研究者来说,解决该问题的方法非常简单:我们可以进行多次测量,通过获取额外的多频相移条纹图像,绝对相位的获取问题就演化为了一个良态的回归问题。我们可以很容易地通过多步相移法13和时间相位展开法14来从这些条纹图像中恢复出被测物的绝对相位信息[图8]。

图7 在计算机视觉中(如图像去模糊),由于从参数空间映射到图像空间的正向物理模型不理想,所产生的逆问题是病态的。典型的解决方案是加入一些有助于正则化的先验假设(平滑),将原始的病态问题重新表述为良态的优化问题

图8 光学计量通过主动控制图像采集过程,将病态的逆问题转化为良态的回归问题。如在条纹投影轮廓术中,通过获取不同频率的额外相移条纹图像,绝对相位可以很容易地通过多频相移法和时间相位展开法来获取

然而当我们走出实验室,进入现实世界的复杂环境时,情况就可能会大相径庭。上述主动策略往往对测量条件和被测对象施加了严格限制,例如:稳定的测量系统、极小的环境干扰、静止的刚性物体等。然而对于许多具有挑战性的应用而言,如恶劣的操作环境与快速运动的物体等,可能使上述主动策略成为一种“奢侈”甚至是不切实际的要求。在这种情况下,传统的光学计量方法将面临严重的物理和技术限制,如有限的数据量和正向模型的不确定性。如何从最少的(最好是单帧)条纹图案中提取高精度的绝对(无歧义)相位信息,仍然是当今光学计量学中最具挑战性的问题之一。因此,我们期待着光学计量学原理和方法的创新和突破,这对其未来的发展具有重要意义。

深度学习作为近年来兴起的一种“数据驱动”技术,在光学计量领域受到越来越多的关注,并在近几年取得了丰硕的成果。不同于传统物理模型驱动的方法,深度学习方法通过人为创建一组由真实目标参数和相应原始测量数据构成的训练集,利用ANN建立了它们的映射关系,从训练数据集中学习网络参数以解决光学计量中的逆问题[图9]。相比于传统的光学计量技术,深度学习将主动策略从实际测量阶段转移到网络训练阶段,从而获得了以下三项前所未有的优势:

(1)从“模型驱动”到“数据驱动”:深度学习颠覆了传统的“物理模型驱动”方式,并开启了基于“数据驱动”的新范式。重建算法(逆映射)可以从实验数据中学习,而不需要有关物理模型的先验知识。若训练数据集是在真实实验环境下(包括测量系统、样品类型、测量环境等)基于主动策略所采集的,且数据量充足(多样性),那么训练出来的模型应该能更精确、更全面地反映真实情况,因此通常会比传统基于物理模型的方法得到更准确的重建结果。

(2)从“分步分治”到“端到端学习”:与传统的独立解决任务序列的传统光学计量方法相比,深度学习允许“端到端”学习结构,其中神经网络可以一步学习原始图像数据与所需样本参数之间的直接映射关系,如图10所示。与“分步分治”方案相比,“端到端”学习方法具有协同作用的优点:它能够在执行不同任务的网络部分之间共享信息(特征),与独立解决每个任务相比有助于获得更好的整体性能。

(3)从“求解线性逆问题”到“直接学习伪逆映射”:深度学习利用复杂的神经网络结构和非线性激活函数来提取样本数据的高维特征,直接学习一个能够充分描述整个测量过程(从原始图像到待测物理量)的非线性伪逆映射模型(“重建算法”)。对于比传统方法的正则化函数或指定先验,深度学习所学习到的先验信息是针对真实实验数据的统计量身定制的,这原则上为求解反问题提供了更强、更合理的正则化。因此其绕过了求解非线性病态逆问题的障碍,可以直接建立输入与期望输出之间的伪逆映射关系。

图9 基于深度学习的光学计量技术

a) 在基于深度学习的光学计量技术中,通过构建一个深度神经网络从数据集中学习图像空间到参数空间的映射关系 b) 通过实验或仿真获得训练数据集的过程。

图10 深度学习与传统算法在条纹投影领域的对比

a) 条纹投影轮廓术的基本原理是基于光学三角测量法的三维重建(左)。其步骤一般包括条纹投影、相位恢复、相位展开和相位-高度映射 b) 基于深度学习的条纹投影轮廓术是由大量训练数据所驱动的,经训练后的网络模型可以直接从单帧条纹中预测出其中所编码的深度信息

由于上述优点,深度学习在光学计量中受到越来越多的关注,为光学计量技术的概念带来了颠覆性的变革。深度学习摒弃了对传统“正向物理模型”和“逆向重构算法”的严格依赖,以“样本数据驱动”的方式重塑了几乎所有光学计量技术中数字图像处理的基本任务,打破了传统光学计量技术的功能/性能疆界,从极少的原始图像数据中挖掘出更多场景的本质信息,显著提升了信息获取能力,为光学计量技术打开了一扇新的大门。图11回顾了在光学计量领域采用深度学习技术的典型研究工作。下面按照传统光学计量技术的图像处理层次列举深度学习在光学计量学中的具体应用案例。

图11 光学计量中的深度学习:由于深度学习为光学计量技术从概念上所带来了重大改变,光学计量学中几乎所有任务的实现方式都被深度学习所革新

(1)图像预处理:早期将深度学习应用于光学计量的工作集中于图像预处理任务,如图像去噪35、图像增强36等。Yan等35构建了一个由20个卷积层组成的CNN来实现条纹图像去噪[图12a]。由于无噪声的理想条纹图像很难通过实验获取,他们仿真了大量添加高斯噪声的条纹图像(网络输入)和相应的无噪声数据(真值)用作神经网络的训练集。图12d-图12e给出传统去噪方法——加窗傅里叶变换法(WFT 37)与深度学习方法的去噪结果。从结果中可见,基于深度学习的方法克服了传统WFT的边缘伪影,表现出更好的去噪性能。Shi等36提出一种基于深度学习的条纹信息增强方法[图13a]。他们将真实场景中捕获的条纹图像和相应的质量增强图像(通过将两幅相移量为π的条纹图像相减获取)用作数据集训练神经网络,以实现对条纹图像到质量增强条纹信息之间的直接映射。图13b-图13d显示了传统傅里叶变换法(FT)38和深度学习方法对运动的手的三维重建结果,从中可见深度学习方法在成像质量上明显优于传统方法。

图12 基于深度学习的条纹图像去噪方法及不同方法的去噪结果35

a) 使用深度学习进行条纹去噪的流程:将带有噪声的条纹图像作为神经网络的输入,直接预测去噪后的图像 b) 输入噪声图像 c) 真实相位分布 d) 深度学习的去噪结果 e) WFT37的去噪结果

图13 基于深度学习的条纹信息增强方法及不同方法下的三维重建结果36

a) 使用深度学习进行条纹信息增加的流程:采集的原始条纹图像和质量增强图像被用来训练DNN,以学习输入条纹图像到输出质量增强条纹信息之间的映射 b) 输入条纹图像 c) 传统FT法38的三维重建结果 d) 深度学习方法的三维重建结果

(2)图像分析:图像分析是光学计量技术中最核心的图像处理环节,因此大多数应用于光学计量学的深度学习技术都是为了处理与图像分析相关的任务。对于相位测量技术,深度学习在相位解调和相位解包裹方面得到了广泛的探索。Zuo等39首次将深度学习技术应用于条纹分析中,并有效提高了FPP的三维测量精度。该方法的思想在于仅采用一幅条纹图像作为输入,利用CNN来模拟传统相移法14的相位解调过程。如图14a所示,构建两个卷积神经网络(CNN1和CNN 2),其中CNN 1负责从输入条纹图像(I)中提取背景信息(A);随后CNN 2利用提取的背景图像和原始输入图像生成所需相位的正弦部分(M)与余弦部分(D);最后,将该输出的正余弦结果代入反正切函数计算得到最终的相位分布。相比于传统单帧相位解调方法 (FT38和WFT37),基于深度学习的方法能够更为准确地提取相位信息,特别是针对具有丰富细节的物体表面,相位精度可提升50%以上,仅采用一幅输入条纹图像但总体测量效果接近于12步相移法[图14b]。该技术目前已被成功应用于高速三维成像,实现了速度高达20000Hz的高精度三维面型测量40[图14c]。Zuo等还进一步将深度学习从相位解调推广至相位展开,提出一种用于单帧三维形貌测量的基于深度学习的几何相位展开方法41。如图15a所示,多视几何系统下捕获的立体条纹图像对及参考面信息被送入CNN中以确定条纹级次。图15b-图15e给出了传统几何相位展开方法42–44和深度学习方法获得的三维重建结果。这些结果表明,基于深度学习的方法在仅投影单帧条纹图像的前提下,可以在更大的测量体积内、更鲁棒地实现对稠密条纹图像的相位展开。

图14基于深度学习的条纹分析方法及不同方法下的三维重建结果39 a) 基于深度学习的条纹分析方法流程:首先通过CNN1从单帧条纹图像I中预测出背景图像A;然后采用CNN2实现条纹图案I、背景图像A与生成所需相位的正弦部分M和余弦部分D之间的映射;最后通过正切函数可以得到高精度包裹相位信息 b) 不同相位解调方法(FT38、WFT37、基于深度学习的方法和12步相移法13)的三维重建的比较 c) 使用深度学习方法对高速旋转的台扇的深度重建结果40

图15基于深度学习的几何相位展开方法及不同方法下的三维重建结果41 a) 由深度学习辅助的几何相位展开方法的流程:CNN1从立体条纹图像对中预测包裹相位信息,CNN2从立体条纹图像对及参考信息中预测条纹级次。通过预测的包裹相位和条纹级次可以恢复绝对相位,然后进行三维重建 b) 结合相移法13、三相机几何相位展开技术42和自适应深度约束法44获取的三维重建结果 c)结合相移法13、双相机几何相位展开技术42获取的三维重建结果 d)基于参考面的几何约束方法43获取的三维重建结果 e)深度学习方法获取的三维重建结果

深度学习也被广泛应用于立体匹配,并获得比传统子集匹配和亚像素优化方法更好的性能。Zbontar和LeCun45提出一种用于立体图像视差估计的深度学习方法[图16]。他们构建了一个暹罗型CNN,通过从两个图像块中学习相似度量来解决匹配成本计算问题。CNN的输出被用于初始化立体匹配成本,然后通过基于交叉的成本聚合和半全局匹配精炼初始成本进而实现视差图估计。图16d-图16h是由传统Census46变换法和深度学习方法获取的视差图像,从中可以看出,基于深度学习的方法实现了更低的错误率和更好的预测结果。Pang等47提出一种用于亚像素匹配的级联CNN架构。如图17a所示,首先通过带有上采样模块的DispFulNet从输入立体图像对中预测初始视差估计,然后通过沙漏结构的DispResNet生成多尺度的残余信号,综合两网络输出最终获取亚像素精度的视差图。图17d-图17g展示了由DispfulNet和DispResNet预测的视差图及误差分布情况。从实验结果可以看出,经过第二阶段DispResNet的优化,视差图的质量得到了明显的改善。

图16 基于深度学习的子集匹配方法及不同方法的视差估计结果45 a) 使用深度学习进行视差图估计的算法流程:暹罗型CNN被构建用于从两个图像块中学习相似度量以解决匹配成本计算问题,并通过一系列后处理最终实现视差估计 b-c) 输入的立体图像 d) 真值 e, g) Census46和CNN获取的视差估计结果

图17 a) 基于深度学习的亚像素匹配方法:首先通过DispFulNet从输入立体图像对中预测初始视差估计,然后通过沙漏结构的DispResNet生成多尺度的残余信号,综合两网络输出最终获取亚像素精度的视差图47 b) 输入立体图像的左视角 c) 真值 d-g) DispfulNet和DispResNet预测的视差图及误差分布情况

(3)后处理:深度学习在光学计量的后处理阶段(相位去噪、误差补偿、数字重聚焦、相位-高度映射等)也发挥着重要作用。如图18a所示,Montresor等48将噪声相位图像的正弦和余弦分量输入CNN中以预测去除噪声的高质量相位图像,预测的相位被再次反馈到CNN中进行迭代提炼以达到更好的去噪效果。图18b-图18e给出了传统WFT37法和深度学习方法的相位去噪结果。实验结果表明CNN能够实现比WFT峰谷相位误差更低的去噪性能。

图18 基于深度学习的相位去噪方法及不同方法的相位去噪结果48 a) 使用深度学习进行相位去噪的流程:噪声相位图像的正弦和余弦分量被输入CNN以预测去除噪声的高质量相位图像,预测的相位被再次反馈到CNN中进行迭代提炼以达到更好的去噪效果 b) 输入噪声相位图像 c) WTF37的去噪结果 d) 深度学习的去噪结果 e) WTF与深度学习方法去噪结果的对比

Li等49提出了一种基于浅层BP神经网络的用于条纹投影轮廓术的相位-高度映射方法。如图19a所示,相机图像坐标及对应的投影仪图像水平坐标被用作网络输入以预测被测物的三维信息。为了获取训练数据,将圆点标定板固定于高精度位移台并在不同的深度位置处捕获标定板的条纹图像。通过提取标定板圆点的亚像素中心,并利用绝对相位计算每个标记中心对应的相机和投影仪图像的匹配点。图19c和图19d是由传统相高转换方法50和神经网络方法获取的阶梯状标准件三维面型结果的误差分布情况,该结果表明基于神经网络的方法可以从大量数据中学习出更加准确的相高模型。

图19 a) 基于学习的相位-深度映射方法:相机图像坐标及对应的投影仪图像的水平坐标被用作网络输入以预测被测物的三维信息49 b) 基于学习的方法获取的阶梯状标准件的三维结果 c、d) 传统相高转换方法50和神经网络方法获取的阶梯状标准件三维面型结果的误差分布情况 e、f) 复杂工件的输入相位图像及输出三维信息

目前,深度学习已逐渐“渗透”进了计算成像与光学测量这一学科中,并在条纹分析、相位恢复、相位展开等方面展现出令人惊叹的性能以及强大的应用潜力。然而,目前深度学习在光学计量领域仍然面临诸多挑战:

(1) 深度学习作为一种数据驱动的技术,其网络输出的性能很大程度上取决于大量标记的训练数据。而大部分光学计量实验的数据采集过程较为复杂耗时,且往往数据采集后无法获取准确可靠的理想真值[图20]。

图20 深度学习在光学计量中的挑战-——获取和标注训练数据的高昂代价。以条纹投影轮廓术为例,采用多频时间相位展开法以投影大量条纹图像为代价获取高质量训练数据。然而在实际操作中,硬件误差、环境光干扰、标定误差等因素使得通过传统的算法很难获取理想真值

(2) 到目前为止,仍然没有任何理论可以清楚地解释针对特定的成像需求,到底选择什么样结构的神经网络最为合适[图21]?

(3) 深度学习的成功通常取决于从训练样本中学习和提取的“共同”特征作为先验信息。因此,当人工神经网络面对“罕见样本”时,它极易给出一个错误的预测结果并且毫无察觉。

(4) 不同于传统基于物理模型方法“透明式”推演过程,当前大多数基于深度学习方法的决策过程通常被认为是由训练数据所驱动的“黑匣子”。而在光学计量中,可解释性往往至关重要,因其确保了错误的可追溯性。

(5) 由于信息并不会”无中生有”,深度学习所获得的结果不可能总是准确可靠的。这对于光学测量的许多应用领域而言往往是致命性的,如逆向工程、自动控制、缺陷检测等。在这些场合,测量结果的准确性、可靠性、可重复性以及可回溯性是首要考虑的因素。

图21 深度学习在光学计量中的挑战——模型设计和算法选择的经验主义。以条纹投影轮廓术中的相位提取为例,同一任务可以由不同的神经网络模型以不同的策略来实现:通过DNN1可以将条纹图像直接映射到相应的相位图;也可通过DNN2从条纹图像和相应的背景图像中输出用于计算相位信息的正切函数的分子项和分母项;使用更强大的DNN,可直接从条纹图像中预测分子和分母

尽管上述挑战还没有得到充分解决,随着计算机科学与人工智能技术的进一步发展,可预计未来深度学习将通过以下三个方面在光学计量中发挥愈发突出的作用:

(1) 搭载深度学习技术发展的“顺风车”,将其中的新兴技术(如对抗学习、迁移学习、自动化机器学习等)运用到光学计量领域,可以促进深度学习在光学计量领域中的广泛接受与认可。

(2) 将贝叶斯统计学与深度神经网络相结合以对估计结果的不确定性进行估计与量化,基于此可以评估神经网络何时产生不可靠的预测51。这在“盲目信任”与“全盘否定”之间给了研究人员另一种可能的选择,即“选择性”采纳。

(3) 描述图像生成的先验知识与物理模型和从实验数据中学习的数据驱动模型二者间协同作用,能够将光学计量领域的更多专业知识引入深度学习框架中,为解决特定的光学计量问题提供更多高效且“物理上合理”的解决方案[图22]。

图22 将物理模型引入深度学习可为特定光学计量问题提供更为“合乎情理”的解决方案。a) 基于端到端网络结构(DNN1)从条纹图像中直接预测包裹相位 b) 端到端策略很难精准复现2π相位截断,导致网络的损失函数训练时无法收敛 c) 将传统相移法的物理模型纳入深度学习,从条纹图像中预测用于计算相位信息的正切函数的分子项和分母项39 d) 结合物理模型的深度学习网络的损失函数训练时可稳定收敛

毋庸置疑,深度学习技术为解决光学计量领域的诸多挑战性问题提供了性能强大且具有发展潜力的全新解决方案,并促进了光学计量学从“基于物理和知识的建模”向“基于数据驱动的学习”范式的转变。大量已发表的文献结果表明,针对特定问题通常基于深度学习的方法能够提供优于传统的基于知识或物理模型的方法的性能,特别是针对许多物理模型复杂且所能获得的信息量有限的光学计量任务。

但不得不承认,目前深度学习技术在光学测量领域仍处于发展的早期阶段。该领域中相当一部分研究人员是严谨且理性的,他们对现阶段缺乏可解释性的“黑匣子”式的深度学习解决方案是抱有质疑的,且对其在工业检测和生物医疗等方面的应用是持观望态度的。我们应该全盘接受深度学习作为我们解决问题“杀手锏”,还是拒绝这样的“黑匣子”解决方案?这是当前光学计量界极具争议的问题。

从正面来看,深度学习的出现为光学计量这一“传统”领域带来新的“生机”。它在光学计量领域的“全面渗透”也向我们展示了人工智能技术为光学计量领域带来巨大的变革的可能性。反过来,我们也不该高估深度学习的力量,并把它当作解决光学计量未来发展所遇到的每个挑战的“万能钥匙”。在具体实践中,我们应理智地评估将深度学习用于特定任务所需的大量数据资源、计算资源和时间成本是否值得。特别是针对很多并不是那么“严苛”的应用场合,传统基于物理模型与“主动策略”的技术能够以更低的复杂度和更高的可解释性获得更好的结果时,我们勇于对深度学习说“不”!

在未来几年内,深度学习是否会取代传统技术在光学计量领域的角色,发挥颠覆性的作用?很明显,没有人可以预测未来,但我们可以参与其中。不管您是光学计量领域钟情于传统技术的“老司机”,还是在该领域涉足不久的“新手上路”,我们都鼓励您能够搭上这趟“顺风车”—— 去大胆地尝试一下深度学习吧!因为它真的很简单,而且往往很奏效!

附注:本文附带了一个深度学习用于单帧条纹分析的示例程序(Supplemental Material File #1)及其详细的步骤指南(Supplementary Information),以方便读者的学习与理解。更多本文相关的详细内容,请点击https://www.nature.com/articles/s41377-022-00714-x来阅读全长54页的论文正文。

论文信息:

该综述以“Deep learning in optical metrology: a review”为题在线发表在Light: Science & Applications。

本文第一作者为南京理工大学左超教授,南京理工大学博士生钱佳铭为共一作者,合著者包括南京理工大学冯世杰副教授、南京理工大学博士生尹维、南京理工大学博士生李艺璇、英国伦敦玛丽女王大学博士生樊鹏飞、南京理工大学韩静副教授、新加坡南洋理工大学钱克矛教授、南京理工大学陈钱教授。

Zuo C., Qian JM., Feng SJ., et al. Deep learning in optical metrology: a review. Light Sci Appl 11, 34 (2022).

参考文献

1.Gåsvik, K. J. Optical metrology. (John Wiley & Sons, 2003).

2.Creath, K. V phase-measurement interferometry techniques. in Progress in optics vol. 26 349–393 (Elsevier, 1988).

3.Aben, H. & Guillemet, C. Integrated photoelasticity. in Photoelasticity of Glass 86–101 (Springer, 1993).

4.Gabor, D. A new microscopic principle. nature 161, 777–778 (1948).

5.Schnars, U., Falldorf, C., Watson, J. & Jüptner, W. Digital holography. in Digital Holography and Wavefront Sensing 39–68 (Springer, 2015).

6.Gorthi, S. S. & Rastogi, P. Fringe projection techniques: whither we are? Opt. Lasers Eng. 48, 133–140 (2010).

7.Pan, B., Qian, K., Xie, H. & Asundi, A. TWo-dimensional digital image correlation for in-plane displacement and strain measurement: a review. Meas. Sci. Technol. 20, 062001 (2009).

8.Marr, D. & Poggio, T. A computational theory of human stereo vision. Proc. R. Soc. Lond. B Biol. Sci. 204, 301–328 (1979).

9.Pitas, I. Digital image processing algorithms and applications. (John Wiley & Sons, 2000).

10.Trusiak, M., Patorski, K. & Wielgus, M. Adaptive enhancement of optical fringe patterns by selective reconstruction using FABEMD algorithm and Hilbert spiral transform. Opt. Express 20, 23463–23479 (2012).

11.Awatsuji, Y. et al. Single-shot phase-shifting color digital holography. in LEOS 2007-IEEE Lasers and Electro-Optics Society Annual Meeting Conference Proceedings 84–85 (IEEE, 2007).

12.Fusiello, A., Trucco, E. & Verri, A. A compact algorithm for rectification of stereo pairs. Mach. Vis. Appl. 12, 16–22 (2000).

13.Zuo, C. et al. Phase shifting algorithms for fringe projection profilometry: A review. Opt. Lasers Eng. 109, 23–59 (2018).

14.Zuo, C., Huang, L., Zhang, M., Chen, Q. & Asundi, A. Temporal phase unwrapping algorithms for fringe projection profilometry: A comparative review. Opt. Lasers Eng. 85, 84–103 (2016).

15.Konolige, K. Small vision systems: Hardware and implementation. in Robotics research 203–212 (Springer, 1998).

16.Hong, C. K., Ryu, H. S. & Lim, H. C. Least-squares fitting of the phase map obtained in phase-shifting electronic speckle pattern interferometry. Opt. Lett. 20, 931–933 (1995).

17.Zuo, C., Chen, Q., Qu, W. & Asundi, A. Phase aberration compensation in digital holographic microscopy based on principal component analysis. Opt. Lett. 38, 1724–1726 (2013).

18.Langehanenberg, P., Kemper, B., Dirksen, D. & Von Bally, G. Autofocusing in digital holographic phase contrast microscopy on pure phase objects for live cell imaging. Appl. Opt. 47, D176–D182 (2008).

19.Wang, Y. & Zhang, S. Optimal fringe angle selection for digital fringe projection technique. Appl. Opt. 52, 7094–7098 (2013).

20.McCulloch, W. S. & Pitts, W. A logical calculus of the ideas immanent in nervous activity. Bull. Math. Biophys. 5, 115–133 (1943).

21.Rosenblatt, F. The perceptron: a probabilistic model for information storage and organization in the brain. Psychol. Rev. 65, 386 (1958).

22.Rumelhart, D. E., Hinton, G. E. & Williams, R. J. Learning representations by back-propagating errors. nature 323, 533–536 (1986).

23.LeCun, Y. et al. Backpropagation applied to handwritten zip code recognition. Neural Comput. 1, 541–551 (1989).

24.Hinton, G. E., Osindero, S. & Teh, Y.-W. A fast learning algorithm for deep belief nets. Neural Comput. 18, 1527–1554 (2006).

25.Krizhevsky, A., Sutskever, I. & Hinton, G. E. ImageNet classification with deep convolutional neural networks. Commun. ACM 60, 84–90 (2017).

26.Nair, V. & Hinton, G. E. Rectified linear units improve restricted boltzmann machines. in ICML (2010).

27.Hinton, G. E., Srivastava, N., Krizhevsky, A., Sutskever, I. & Salakhutdinov, R. R. Improving neural networks by preventing co-adaptation of feature detectors. ArXiv Prepr. ArXiv12070580 (2012).

28.Chen, J. X. The evolution of computing: AlphaGo. Comput. Sci. Eng. 18, 4–7 (2016).

29.LeCun, Y., Bengio, Y. & Hinton, G. Deep learning. Nature 521, 436–444 (2015).

30.Ouyang, W. et al. DeepID-Net: Object detection with deformable part based convolutional neural networks. IEEE Trans. Pattern Anal. Mach. Intell. 39, 1320–1334 (2016).

31.Doulamis, N. & Voulodimos, A. FAST-MDL: Fast Adaptive Supervised Training of multi-layered deep learning models for consistent object tracking and classification. in 2016 IEEE International Conference on Imaging Systems and Techniques (IST) 318–323 (IEEE, 2016).

32.Dong, C., Loy, C. C., He, K. & Tang, X. Image super-resolution using deep convolutional networks. IEEE Trans. Pattern Anal. Mach. Intell. 38, 295–307 (2015).

33.Long, J., Shelhamer, E. & Darrell, T. Fully convolutional networks for semantic segmentation. in Proceedings of the IEEE conference on computer vision and pattern recognition 3431–3440 (2015).

34.Ronneberger, O., Fischer, P. & Brox, T. U-net: Convolutional networks for biomedical image segmentation. in International Conference on Medical image computing and computer-assisted intervention 234–241 (Springer, 2015).

35.Yan, K. et al. Fringe pattern denoising based on deep learning. Opt. Commun. 437, 148–152 (2019).

36.Shi, J., Zhu, X., Wang, H., Song, L. & Guo, Q. Label enhanced and patch based deep learning for phase retrieval from single frame fringe pattern in fringe projection 3D measurement. Opt. Express 27, 28929 (2019).

37.Kemao, Q. Windowed Fourier transform for fringe pattern analysis. Appl. Opt. 43, 2695–2702 (2004).

38.Takeda, M., Ina, H. & Kobayashi, S. Fourier-transform method of fringe-pattern analysis for computer-based topography and interferometry. JosA 72, 156–160 (1982).

39.Feng, S. et al. Fringe pattern analysis using deep learning. Adv. Photonics 1, 025001 (2019).

40.Feng, S., Zuo, C., Yin, W., Gu, G. & Chen, Q. Micro deep learning profilometry for high-speed 3D surface imaging. Opt. Lasers Eng. 121, 416–427 (2019).

41.Qian, J. et al. Deep-learning-enabled geometric constraints and phase unwrapping for single-shot absolute 3D shape measurement. APL Photonics 5, 046105 (2020).

42.Tao, T. et al. Real-time 3-D shape measurement with composite phase-shifting fringes and multi-view system. Opt. Express 24, 20253 (2016).

43.An, Y., Hyun, J.-S. & Zhang, S. Pixel-wise absolute phase unwrapping using geometric constraints of structured light system. Opt. Express 24, 18445–18459 (2016).

44.Tao, T. et al. High-speed real-time 3D shape measurement based on adaptive depth constraint. Opt. Express 26, 22440 (2018).

45.Zˇbontar, J. & LeCun, Y. Stereo matching by training a convolutional neural network to compare image patches. 32.

46.Mei, X. et al. On building an accurate stereo matching system on graphics hardware. in 2011 IEEE International Conference on Computer Vision Workshops (ICCV Workshops) 467–474 (IEEE, 2011).

47.Pang, J., Sun, W., Ren, J. SJ., Yang, C. & Yan, Q. Cascade Residual Learning: A Two-Stage Convolutional Neural Network for Stereo Matching. in 2017 IEEE International Conference on Computer Vision Workshops (ICCVW) 878–886 (IEEE, 2017). doi:10.1109/ICCVW.2017.108.

48.Montresor, S., Tahon, M., Laurent, A. & Picart, P. Computational de-noising based on deep learning for phase data in digital holographic interferometry. APL Photonics 5, 030802 (2020).

49.Li, Z., Shi, Y., Wang, C., Qin, D. & Huang, K. Complex object 3D measurement based on phase-shifting and a neural network. Opt. Commun. 282, 2699–2706 (2009).

50.Li, Z., Shi, Y., Wang, C. & Wang, Y. Accurate calibration method for a structured light system. Opt. Eng. 47, 053604 (2008).

51.Feng, S., Zuo, C., Hu, Y., Li, Y. & Chen, Q. Deep-learning-based fringe-pattern analysis with uncertainty estimation. Optica 8, 1507–1510 (2021).

本文注明来源为其他媒体或网站的文/图等稿件均为转载,如涉及版权等问题,请作者在20个工作日之内联系我们,我们将协调给予处理。最终解释权归旭为光电所有。