机器学习“携手”双锥对撞点火,助力激光波形优化

激光聚变研究中的机器学习

随着超级计算机和数据科学的迅速发展,机器学习已成功地应用于激光聚变研究。例如,Gopalaswamy等人通过使用贝叶斯推理建立了一维流体力学模拟和三维实验数据之间的关系,助力OMEGA激光装置的中子产额增加了两倍[1]。Humbird等人使用迁移学习,用模拟数据和实验数据训练深度神经网络,极大地提高了计算模型的预测能力[2]。Peterson等人使用随机森林算法建立了基于二维HYDRO程序的替代模型,并在美国国家点火装置(NIF)发现了一种新的内爆模式[3]。

在给定的驱动能量下优化脉冲激光,可以获得满足高面密度、高离子温度和低飞行形状因子的内爆。上海交通大学张杰院士团队的吴福源等人从此研究点入手,通过使用机器学习优化激光波形,发现其对激光聚变实验的优化设计具有重要意义。相关内容发表在High Power Laser Science and Engineering 2022年第2期中。

实现激光波形的高效优化

作者通过机器学习中的遗传算法和随机森林算法引导的大规模流体力学模拟,实现了激光波形的高效优化。与传统方法相比,机器学习方法能够将双锥对撞后的燃料面密度提高63%,同时将表征流体不稳定性的飞行形状因子(用厚度归一化的内爆壳层半径大小)降低30%。

2021年8月,在神光-II升级激光装置上进行的双锥对撞点火(Double-Cone-Ignition, DCI)实验成功演示了这种设计方法的有效性。本文提出的智能优化设计方法,不仅适用于直接驱动激光聚变,同时也适用于间接驱动激光聚变等聚变方案。

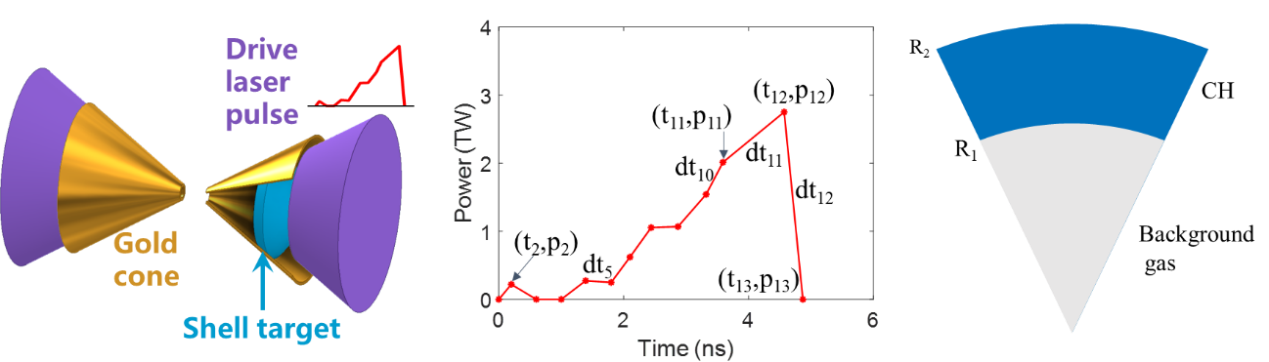

图1给出了DCI方案的激光波形和靶结构示意图。在基于MULTI-IFE程序的优化过程中,保持金锥和球冠靶的参数不变,描述激光波形功率点的参数可以在巨大的参数空间中自由变化,这使得传统方法变得非常耗时。通过采用机器学习方法,将激光波形的优化周期从过去的14天缩短到了2天,大幅提高了激光波形的优化效率和优化质量。

图2给出了机器学习优化过程中的典型激光波形,其中内爆性能的好坏用激光波形的适应度大小表征。由该图可知,由于机器学习算法的引导作用,激光波形从早期广泛分布(黑色)收敛到一个狭窄的区域(红色)。对于早期的激光波形来说,有的激光功率太低,有的脉冲时间太短,对应的驱动能量很小。在遗传算法的自然选择过程中,这些能量较小的激光波形不容易存活下来,因为它们的适应度较低。

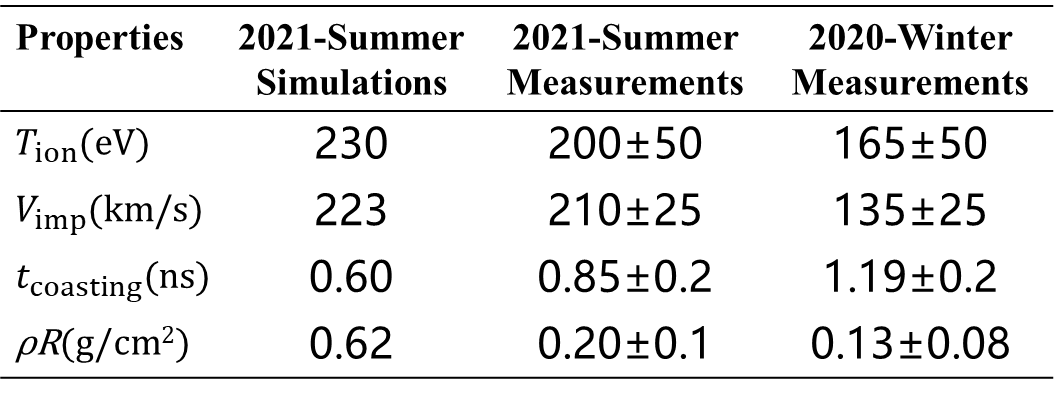

表1对比了机器学习方法和传统方法获得的计算和实验结果。由该表可知,机器学习优化得到模拟结果和实验结果具有良好的一致性。例如,对撞时的峰值离子温度约为200 eV,峰值内爆速度约为210 km/s,滑行时间约为0.85 ns。这种一致性表明,尽管存在由流体不稳定性和激光辐射不均匀性等高维扰动,但球冠靶的主体部分在实现了球形内爆。表1还列出了采用手动优化方法设计的2020年12月实验结果。通过对比可知,机器学习优化确实显著提高了实验结果。

表1 机器学习(2021年)和传统方法(2020年)获得的结果对比

前景与展望

研究人员目前正在进行更高维度下的激光波形优化研究,以支撑更大驱动激光能量下的DCI实验,验证DCI方案在开展高能量密度物理研究和实现聚变能源方面的潜在优势。

免责声明:本文旨在传递更多科研资讯及分享,所有其他媒、网来源均注明出处,如涉及版权问题,请作者第一时间联系我们,我们将协调进行处理,最终解释权归旭为光电所有。