集成深度学习:更精准的条纹图像分析 | Advanced Photonics Nexus

本文为中国激光第3043篇。

欢迎点击在看、转发,让更多人看到

研究背景

光学计量是以光信号作为信息载体的测量科学和技术,同时也是一门历史悠久的学科,物理学的发展从一开始就为光学计量技术所驱动。随着激光、电荷耦合器件(CCD)和计算机的发明,光学计量经历了重大变革。现如今,它已发展成为一个涵盖广泛的跨学科领域,并与光测力学、计算机视觉和计算成像等学科紧密相关。

作为光学计量的代表性技术之一,光学相位测量技术具有非接触、高分辨率、高速度和全场自动化等优点,被广泛应用于工业检测、机器视觉、生物医学和纳米结构表征等科学研究和工程实践领域。该技术通过相干光干涉叠加或非相干投影的方式在物体表面生成周期性的结构条纹,并将待测物体的相关物理量(如面形、位移、应变、粗糙度和尺寸)直接或间接地反映在采集到的条纹图案中。如何从单幅条纹图像中高精度地还原复杂面形的相位信息,一直是本领域研究人员不断追求的核心目标。图1显示了条纹投影轮廓术的测量原理。

图1 条纹投影轮廓术测量原理

近年来,以深度学习为代表的人工智能技术全面进入了大众的视野。特别地,以ChatGPT为代表的大模型已将人工智能技术的影响力从“量变”提升到“质变”。与此同时,人工智能也已经在计算机视觉、图像处理等多个领域的技术上取得了全面的突破,并且在光学成像、计算成像、全息显微等领域展现出巨大的潜力。在光学计量领域,得益于与前沿人工智能技术的交叉和融合,基于深度学习的单帧条纹图案分析已经展现了突出的效果并且引起了广泛的关注。作为一种数据驱动方法,它能够利用被传统物理模型所忽视的隐藏线索,具有解决相位解调中效率与准确性矛盾的潜力。

然而,在处理从未曾见过的场景时,深度学习方法的相位解调并非每次都表现完美。一个常被忽视的问题是,人们往往期待某一个深度神经网络能处理和应对所有的待测场景,而这种做法其实存在风险。其原因在于:由于结构固定,单一神经网络可能只学习了输入数据的特定且有限特征。因此,在应对未知情况下,其泛化能力有限,容易给出具有高方差的预测结果。此外,在训练期间,神经网络可能会收敛到损失函数的局部最小值,从而进一步增加了做出不可靠预测的风险。

创新研究

人们常言“众人拾柴火焰高”、“人多力量大”。为了解决上述问题,研究人员提出了集成深度学习技术。该技术不依赖于单个神经网络模型,而是组合多个基本模型来协同执行任务。由于不同网络的体系结构可以捕获不同的信息,通过组合不同的网络,该技术可以做出更可靠的决策。受此启发,来自南京理工大学的研究团队近日提出了一种基于集成深度学习的条纹分析方法,文章以“Fringe-pattern analysis with ensemble deep learning”为题,发表在 Advanced Photonics Nexus 2023年第3期。该工作通过发挥多个具有不同架构的先进基础模型特点并对每个基础模型的预测结果进行自适应合成,可有效提升深度学习网络模型在条纹相位分析任务中的预测精度和泛化性。

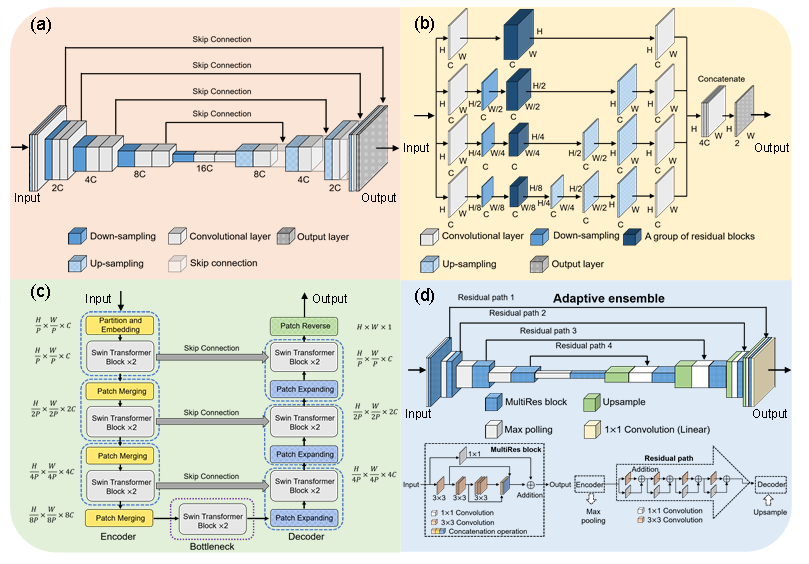

如图2所示,该工作采用了三个先进的条纹分析模型作为基础模型:基于卷积神经网络的U-Net、多路径网络和基于transformer的Swin-Unet(模型结构如图3所示)。首先,研究团队以单幅条纹图像为输入,采用K-fold平均集成法对训练数据进行划分,用不同的数据集对各自神经网络进行多次训练并且计算平均预测反正切函数的分子项与分母项。随后,研究团队通过构建自适应集成神经网络对每个基础模型的输出进行全自动、自适应融合,进而得到最终的预测结果。

图2 本方法的原理图

图3 (a) U-Net神经网络模型(基础模型1);(b) 多路径神经网络模型(基础模型2);(c) Swin-Unet神经网络模型(基础模型3);(d) MultiResUNet神经网络模型(自适应集成神经网络)

实验分析

为了验证本方法的有效性,研究团队构建了一套基于条纹投影的三维测量系统,并利用该系统采集了条纹图作为训练集且利用多步相移法计算生成了相应的训练标签。训练过程中,首先将训练数据分成七份,使用7-fold平均集成法来训练每个基础模型。然后以MultiResUNet架构为基础,构建自适应集成神经网络,自动融合所有基础模型的输出,生成最终结果。

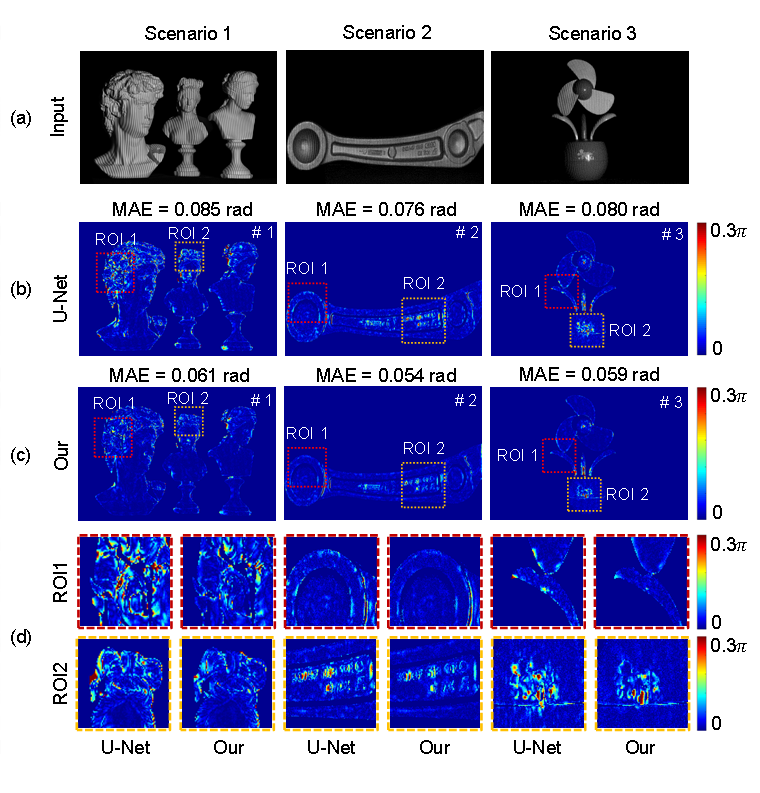

如图4(a)所示,测试过程中利用三个从未见过的场景(一个石膏组合场景、一个铝合金工业零件和一个塑料桌面风扇)来研究本方法的表现。图4(b)-(d)显示了U-Net和该方法的绝对相位误差比较。从平均绝对误差来看,对于这三个场景而言,使用本方法时,相位精度都可得到显著提升。其中第一个场景精度提升了28.2%,第二个场景提升了28.9%,第三个场景提升了26.3%。从挑选的两个复杂感兴趣区域来看,与U-Net相比,本方法在处理存在深度变化和边缘轮廓跳变的复杂区域具有更好表现。此外研究团队也进一步研究了单个多路径网络和单个Swin-Unet 的表现,结果表明,不同的网络在不同的场景下具有不同的表现,而采用本方法集成这些网络的预测结果时,可得到最为准确的相位预测结果。

图4 相位测量误差分析:(a)三个场景的输入光栅图像;(b)和(c)分别为U-Net和本方法的绝对相位误差图;(d)两个感兴趣区域的误差分布对比

总结与展望

本项研究提出了一种基于集成深度学习的全新条纹图案分析方法。该方法可以综合利用多个先进深度神经网络的集体贡献,自动融合生成理想的相位预测结果。由于不同的网络具有不同的结构特点,这有利于通过训练提取输入数据不同方面的特征。借助这些模型的“集体智慧”,即融合这些不同属性的特征,可消除单一神经网络模型的隐含方差,进而大大提高集体预测的性能。

实验结果表明,在处理未知场景时,该方法的相位预测精度不仅优于传统基于物理模型的方法,更超越了各神经网络单独使用时的表现。正所谓“众人拾柴火焰高”,这种运用集体智慧的思想也适用于其他基于深度学习的光学计量任务之中。从“单打独斗”到“协同作战”,智能光学计量技术的发展将迎来新范式。

团队介绍

南京理工大学智能计算成像实验室(SCILab: www.scilaboratory.com)隶属于南京理工大学副校长、长江学者陈钱教授领衔的“光谱成像与信息处理”教育部长江学者创新团队、首批“全国高校黄大年式教师团队”。

实验室学术带头人左超教授为国家“优青”、美国光学学会/国际光学工程学会会士(Optica/SPIE Fellow),入选科睿唯安全球高被引科学家、Elsevier中国高被引学者等。实验室致力于研发新一代计算成像与传感技术,在国家重大需求牵引及重点项目支持下开展新型光学成像的机理探索、工程实践以及先进仪器的研制工作,并开拓其在光学计量、光学显微、生命科学、生物医药、智能制造、遥感监测以及军事国防领域的前沿应用。研究成果已在SCI源刊上发表论文180余篇,其中20余篇论文被选作Adv. Photon等期刊封面论文,20篇论文入选ESI高被引论文/热点论文,论文被引超过10000次。获中国光学工程学会技术发明一等奖、江苏省科学技术奖基础类一等奖、日内瓦国际发明展 “特别嘉许金奖”等。

实验室研究生5人次获全国光学工程优秀博士论文/提名,4人次获得中国光学学会王大珩光学奖,5人次入围Light全国光学博士生学术竞赛全国百强,获全国“挑战杯”、“互联网+”、“创青春”、“研电赛”特等奖/金奖十余次。

免责声明:本文旨在传递更多科研资讯及分享,所有其他媒、网来源均注明出处,如涉及版权问题,请作者第一时间联系我们,我们将协调进行处理,最终解释权归旭为光电所有。