2D图像输入实时学习生成3D逼真全息图的端到端方法

TITLE | #2D图像输入实时学习生成3D逼真全息图的端到端方法#

实现全息成像的一个主要难点,是执行全息波前传播的衍射模拟所需的巨大计算成本。为解决这个问题,已经产生了许多用于数值衍射的加速算法,例如查找表、波前记录平面、多层深度离散化以及使用图形处理单元(GPU)计算。近来,基于深度学习的CG生成策略显示出了显著加快实时CGH生成的运行速度和高质量显示结果,如多深度图像或红、绿、蓝和深度(RGB-D)信息,然而这些方法仍然严重依赖大量体积式3D光波数据输入,对原始3D目标的CGH生成的预获取和表示进一步限制了其应用。

创建用于计算机生成全息图的3D数据集是解决CGH计算效率的另一个难点。常规的解决方法是采用飞行时间(TOF)相机、光场相机、立体相机或基于液体透镜的相机等3D相机来获取密集和深度的3D信息,但它们都固有一定的局限性,不能精确地描绘实时和真实的3D几何场景,需要严格的设备校准和耗时的后处理算法。一个更有吸引力的策略是从2D图像逆向转换3D波前。由于这个任务的不适定性,使用传统算法从单个图像进行深度估计的尝试在存在特定线索的情况下受到限制。尽管深度卷积神经网络(CNN)可以以更强大的方式进行更好的泛化处理,但收集用于监督式网络训练的高质量和多样化的“图像+深度”配对数据集仍然是一项具有挑战性的任务。

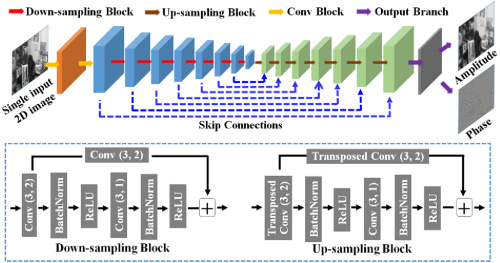

对于数据集的创建,作者通过引入一种完全自动的2D图像到3D全息图数据集合成方法来解决创建大规模训练数据集的问题,该方法只需要一系列单个图像。作者将这种方法称为“MiDaS基于衍射的方法”,它使用一种最先进的现成的单眼深度估计器,称为MiDaS ,首先对每个训练图像进行深度图预测,然后结合图像对深度预测进行进一步精细化处理,使用数值衍射算法计算出3D全息图。通过这样的方式,开辟了一种通过任何2D图像合成大量数据集的方法。

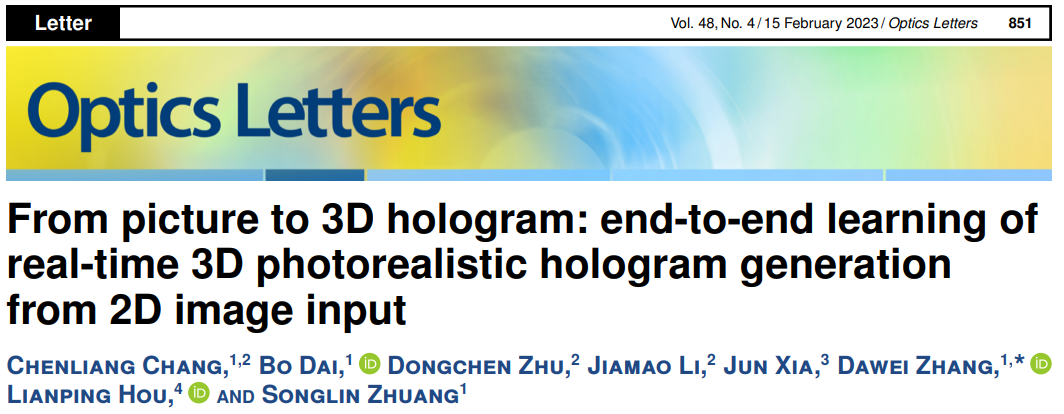

根据MiDaS基于衍射的方法合成的大规模训练数据集包含2D图像和相应的标注全息图数据,并将其馈入CNN进行端到端的有监督训练,使用均方误差(MSE)损失函数进行训练。为了最大化CNN学习适应不同测试领域的能力,作者通过从流行的自然图像数据集COCO2017 随机选择3万个和1000个单个图像来生成训练数据集和验证数据集。作者将所有图像大小调整为1024×512像素,并连续应用单目深度估计器来计算相应的标注复杂全息图数据。在作者的计算中,将所有图像场景的8位深度范围设置为从z=0.001 m(近平面)到z=0.005 m(远平面)并进行归一化。计算假设波长为532nm,像素间距为6.4µm。作者的CNN是在搭载NVIDIA GeForce RTX 2060 GPU的平台上使用Adam优化器进行训练,批量大小为2,迭代30个epochs。学习率从0.0001开始,每10个epochs减半。

图像的输入中直接合成3D全息图。作者设计了一个完全自动的流程,通过将任何一组真实生活中的图像转换为2D图像和对应的3D全息图对来创建大规模数据集,并以监督学习的方式端到端地训练卷积神经网络(CNN)。本文所述的方法仅凭借2D图像内容就能高效生成3D全息图,为从日常图片中实时创建3D全息提供了新的途径。

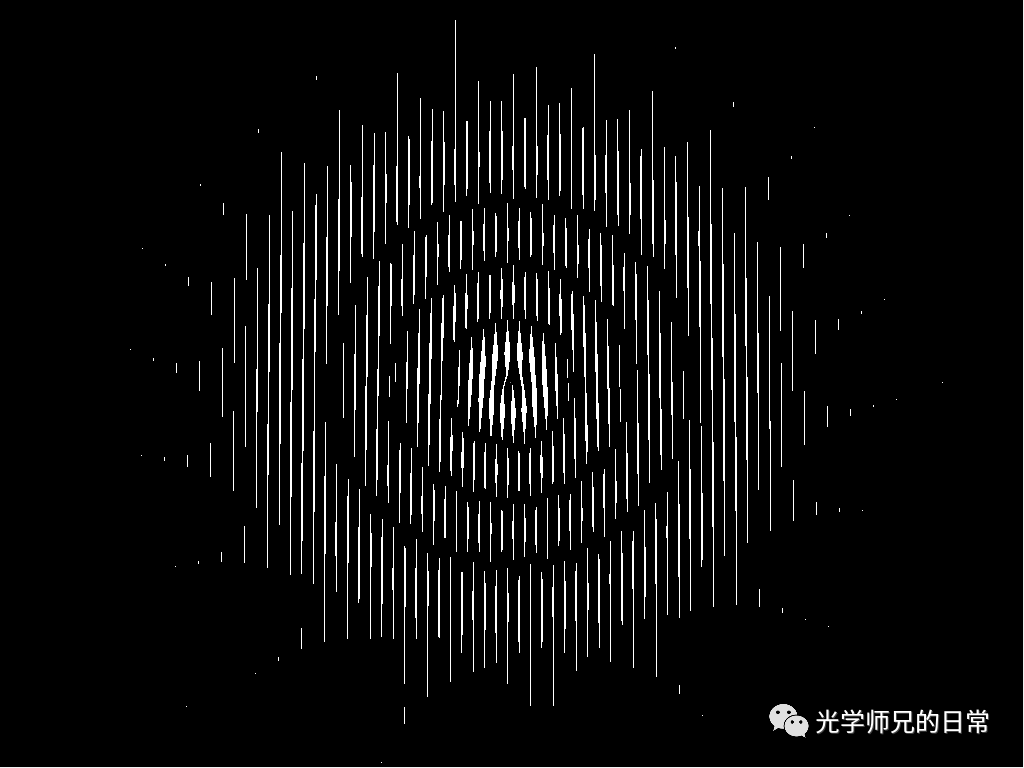

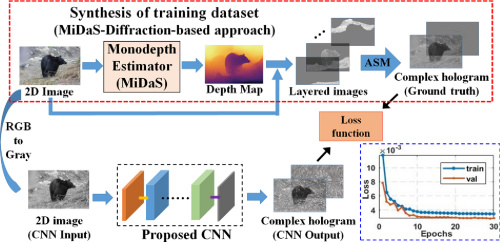

图3(b)-图3(e)比较了从标注全息图数据[图3(b)和图3(c)]和CNN预测全息图[图3(d)和图3(e)]重新调焦后的景深图像。结果在前景和背景平面呈现出视觉上相似的重建图像。CNN从输入图像中推断全息图的总运行时间在GPU上为0.0175秒,在CPU上(Intel Core i9-10900)为0.7661秒,具有实时计算性能。

https://doi.org/10.1364/OL.478976

免责声明:本文旨在传递更多科研资讯及分享,所有其他媒、网来源均注明出处,如涉及版权问题,请作者第一时间联系我们,我们将协调进行处理,最终解释权归旭为光电所有。